KI-Gesetz der EU: DAS sind die wichtigsten Punkte

Die EU bringt gerade eine der weltweit ersten umfassenden Verordnungen zur künstlichen Intelligenz auf den Weg. Nach dem ersten Vorschlag für ein KI-Gesetz im April 2021 geht der Entwurf nun in die letzte Verhandlungsphase. Dabei haben sich die politischen Entscheidungsträger das Ziel gesetzt, noch vor Jahresende einen endgültigen Wortlaut zu verabschieden. Angesichts der Reichweite der Verordnung und der zu erwartenden Auswirkungen innerhalb und außerhalb der EU-Grenzen, möchte ich die Gelegenheit nutzen, um einige noch in der Diskussion befindliche Kernaspekte und deren mögliche Folgen für die KI-Nutzung und -Innovation in Europa zu beleuchten.

Warum sich Splunk dafür interessiert

Splunk nutzt KI, um die menschliche Entscheidungsfindung bei der Erkennung, Untersuchung und Reaktion auf Incidents zu beschleunigen. Min Wang, Chief Technology Officer bei Splunk, hat kürzlich in einem Blog geschrieben: „Produktivität und Effizienz lassen sich drastisch steigern, wenn Fachleute von Routineaufgaben befreit werden und sich stärker werthaltigen Projekte zuwenden können. Wir sind der Überzeugung, dass die Vorteile von KI die Nachteile bei Weitem überwiegen. Darum investieren wir verstärkt in den weiteren Ausbau unserer bereits bewährten KI-Funktionen.“ Der neue Splunk AI Assistant (Vorschau) nutzt beispielsweise generative KI für ein Chat-Erlebnis, bei dem Kunden beim Verfassen und Erlernen von SPL (Search Processing Language) durch Interaktion in einfachem Englisch unterstützt werden.

Splunk verfolgt einen domänenspezifischen KI-Ansatz (mit einer Reihe von Use Cases im Sicherheits- und Observability-Bereich), der offen und erweiterbar (leicht in Drittanbieter-Frameworks integrierbar) ist und auf menschlicher Überwachung basiert.

Bei Splunk verfolgen wir alle politischen und regulatorischen Entwicklungen rund um KI sehr aufmerksam, und das KI-Gesetz der EU nimmt hier eine besondere Stellung ein. Als einer der ersten Versuche, einen rechtlichen Rahmen für KI zu schaffen, könnte es unserer Meinung nach in naher Zukunft auch anderen Gesetzgebern als Anregung dienen. Insbesondere ist es für uns von Interesse, wie einige Grundsätze des KI-Gesetzes der EU sich in einen künftigen KI-Verhaltenskodex zwischen der EU und den USA einbinden ließen.

Der aktuelle Stand

Seit der Veröffentlichung des Vorschlags im Jahr 2021 gab es in Brüssel selten so viel Aufregung und Leidenschaft im Ringen um einen Gesetzestext wie bei diesem. Im Europäischen Parlament sind zwei Ausschüsse gemeinsam für die Verordnung verantwortlich (unter der Leitung der beiden Mitberichterstatter, des italienischen Sozialdemokraten Brando Benifei und des rumänischen Liberalen Dragoș Tudorache). Fünf weitere Ausschüsse haben Stellungnahmen abgegeben. KI geht im Europäischen Parlament offenbar alle etwas an. In den Hauptausschüssen wurden im Juni 2022 sage und schreibe 3.312 Änderungsanträge eingereicht, und es dauerte ein Jahr, bis das Parlament alle Änderungsanträge geprüft und seine Verhandlungsposition verabschiedet hatte.

Im EU-Ministerrat schritten die Gespräche schneller voran. Unter der Initiative der französischen Ratspräsidentschaft (Juli bis Dezember 2022) legte der Rat seine allgemeine Ausrichtung im Dezember 2022 fest. Beide Institutionen sind jetzt bereit zu „Trilogen“ mit der Europäischen Kommission. Dabei handelt es sich um Verhandlungen hinter verschlossenen Türen, bei denen politische Entscheidungsträger den Text Artikel für Artikel durchgehen und versuchen, sich auf eine Kompromissposition zu einigen. Die Position des Parlaments war das Ergebnis eines fragilen Kompromisses zwischen den Fraktionen. Daher haben die Mitberichterstatter bei den laufenden Verhandlungen wenig Spielraum.

Bis dato haben bereits zwei Triloge stattgefunden (im Juli), zwei weitere werden am 2./3. Oktober und am 25. Oktober stattfinden. Die spanische EU-Ratspräsidentschaft und die Mitberichterstatter des Parlaments stehen unter Druck, da die Verhandlungen bis Ende Oktober abgeschlossen sein sollten.

Vier Herausforderungen

Seit Veröffentlichung des Vorschlags verfolgt die Europäische Kommission ein und dasselbe Ziel: Die risikoreichen Anwendungen von KI sollen im Interesse von Gesundheit, Sicherheit und Grundrechtsschutz reguliert werden, ohne die Fähigkeit Europas zur Innovation mit KI in Frage zu stellen. Das ist die 1. Herausforderung.

Die Kommission hat außerdem die Schaffung eines horizontalen Rahmens mit gemeinsamen Regeln für alle Sektoren und unter Berücksichtigung einiger sektoraler Besonderheiten angestrebt. Das ist die 2. Herausforderung.

Darüber hinaus waren die EU-Institutionen bestrebt, ein zukunftssicheres Regelwerk zu schaffen, das mit den technologischen Entwicklungen Schritt halten kann. Das ist die 3. Herausforderung.

Und schließlich ist die KI-Wertschöpfungskette komplex: Unterschiedliche Akteure sind an der Konzeption, Entwicklung und Bereitstellung von KI-Systemen beteiligt. Gesetzliche Verpflichtungen sollten daher jeweils die Partei betreffen, die am besten in der Lage ist, das mit einem bestimmten KI-System einhergehende Schadensrisiko zu mindern. Das Streben nach einer angemessenen Verteilung der Verantwortlichkeiten ist die 4. Herausforderung.

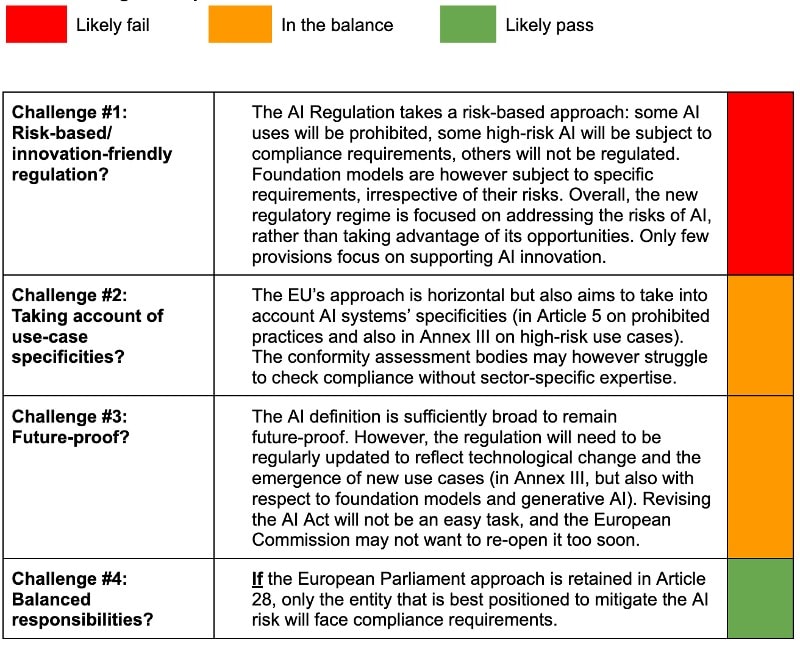

Ich sehe diese Herausforderungen bei der Bewertung der Effizienz und Leistungsfähigkeit der endgültigen Fassung der KI-Verordnung als geeignete Tests an. Während wir die Punkte erörtern, über die in den Trilogen diskutiert wird, können wir uns bereits die Frage stellen, wie der endgültige Wortlaut bei diesen Tests abschneiden wird. Eine erste Einschätzung findet ihr in der Scorecard am Ende dieses Blogs.

Wichtige Aspekte

Definition von KI

Was ist KI eigentlich? Es gibt ebenso viele Definitionen wie Menschen oder Organisationen, die versuchen, KI zu definieren. Laut OECD ist „ein KI-System ein maschinengestütztes System, das für eine gegebene Menge definierter Ziele Ergebnisse hervorbringen kann (Vorhersagen, Empfehlungen oder Entscheidungen), die das Umfeld beeinflussen.“ Die britische Regierung definiert KI hingegen als „Nutzung digitaler Technologie zur Schaffung von Systemen, die Aufgaben ausführen können, für die nach allgemeinem Verständnis Intelligenz erforderlich ist.“

Die Europäische Kommission hatte ursprünglich (in Anhang I) eine KI-Definition vorgeschlagen, die als zu weit gefasst galt, da sie auch Techniken umfasste, bei denen es sich nicht immer um KI, sondern teils „nur“ um herkömmliche Software handelte. Parlament und Rat schlugen einhellig vor, Anhang I zu streichen. Das Europäische Parlament hat mittlerweile eine Definition unter Artikel 3 Absatz 1 vorgeschlagen, die mit der Formulierung der OECD in Einklang steht und zukunftssicher sein kann: „ein maschinengestütztes System, das so konzipiert ist, dass es mit unterschiedlichen Graden an Autonomie operieren kann, und das für explizite oder implizite Ziele Ergebnisse wie Vorhersagen, Empfehlungen oder Entscheidungen hervorbringen kann, die das physische oder virtuelle Umfeld beeinflussen.“ Die OECD arbeitet gerade an einer neuen KI-Definition (die bis Oktober/November fertiggestellt sein soll). Diese dürfte sich auf die EU-Verhandlungen zu diesem Thema auswirken.

Verbot einiger KI-Systeme (Titel II)

Einige KI-Systeme werden als „unannehmbares Risiko“ eingestuft und daher in der künftigen Verordnung verboten. Die Mitgliedsstaaten und das Parlament sind sich beispielsweise darin einig, dass Systeme zur Bewertung des sozialen Verhaltens durch öffentliche Behörden („Social-Scoring-Systeme“) verboten werden sollen. Die abschließende Liste verbotener Praktiken wird jedoch eine hoch politische Angelegenheit sein. Mitgliedsstaaten möchten z. B. die Möglichkeit haben, biometrische Fernidentifizierungssysteme (unter bestimmten Bedingungen) in Echtzeit für Strafverfolgungszwecke einzusetzen. Das Europäische Parlament hingegen will deren Anwendung im öffentlichen Raum untersagen.

Das Parlament ist der Ansicht, dass prädiktive polizeiliche Systeme (basierend auf Profiling, Standort oder kriminellem Verhalten in der Vergangenheit) sowie Systeme zur Erkennung von Emotionen in den Bereichen Strafverfolgung und Grenzmanagement sowie am Arbeitsplatz und in Bildungseinrichtungen ebenfalls verboten werden sollten. Die Position des Parlaments in Bezug auf Verbote wird von Mitgliedstaaten als inakzeptabel erachtet, die weiterhin die Freiheit haben möchten, einige KI-Systeme zu Strafverfolgungszwecken einzusetzen.

Definition von „Hochrisiko“-KI-Systemen (Titel III, Kapitel 1)

Hochrisiko-KI-Systeme sollen unter der Voraussetzung zugelassen werden, dass sie bestimmten KI-Anforderungen entsprechen und vorab eine Konformitätsbewertung durchgeführt wird. Hochrisiko-KI-Systeme werden in Anhang III der KI-Verordnung angeführt. In Bezug auf die hier aufgelisteten kritischen Use Cases herrscht große Übereinstimmung, wobei das Europäische Parlament einige Anwendungsfälle wie KI-Systeme, die „bestimmungsgemäß verwendet werden sollen, um das Ergebnis einer Wahl (…) oder das Wahlverhalten natürlicher Personen (…) zu beeinflussen“ hinzugefügt hat.

Darüber hinaus soll diese Liste durch eine Definition des Begriffs „Hochrisiko“ in Artikel 6 Absatz 2 weiter präzisiert werden. Das Europäische Parlament besteht dabei auf der Formulierung „wenn sie aufgrund ihrer Zweckbestimmung ein erhebliches Risiko bergen, die Gesundheit und Sicherheit oder die Grundrechte von Personen (…) zu schädigen“, während der Rat vorschlägt, alle unter Anhang III aufgelisteten Use Cases als „Hochrisiko“ einzustufen, es sei denn, die Ergebnisse des entsprechenden Systems seien rein akzessorisch und würden daher wahrscheinlich nicht zu einem erheblichen Risiko für die Gesundheit, Sicherheit oder Grundrechte führen. Wir unterstützen den Ansatz des Parlaments unter Artikel 6 Absatz 2, da er mehr Klarheit schafft.

Anforderungen an Hochrisikosysteme (Titel III, Kapitel 2)

Die Compliance-Anforderungen für Hochrisiko-KI-Systeme waren nicht Gegenstand großer Debatten zwischen den Mitgliedsstaaten und den Parlamentariern. Es besteht zu weiten Teilen Einigung über die abschließende Liste der Verpflichtungen, die wohl Anforderungen in den Bereichen Data Governance, technische Dokumentation, Aufzeichnung (Protokollierung), Transparenz, menschliche Überwachung, Genauigkeit, Robustheit und Cybersicherheit beinhalten wird.

Wir erwarten allerdings Diskussionen über die Forderung des Parlaments, für Hochrisiko-KI-Systeme vor deren Einführung auf dem EU-Markt eine grundrechtliche Folgenabschätzung einzuführen, die einigen nationalen Delegationen zu weit gehen dürfte.

Verteilung der Verantwortlichkeiten in der KI-Wertschöpfungskette

Die KI-Lieferkette ist wie gesagt komplex. Seit 2021 suchen EU-Mitgliedsstaaten und Abgeordnete nach Möglichkeiten, die Verantwortlichkeiten richtig unter den Akteuren der Lieferkette aufzuteilen. Das Parlament hat in seinem Änderungsvorschlag zu Artikel 28 einen sinnvollen Ansatz gefunden, indem es festlegt, dass Händler, Importeure, Betreiber oder sonstige Dritte für die Zwecke der Verordnung als Anbieter eines Hochrisiko-KI-Systems gelten und den Anbieterpflichten unterliegen, wenn sie ein KI-System, das nicht als Hochrisiko-KI-System eingestuft wurde, so wesentlich verändern, dass es zum Hochrisiko-KI-System wird. Kurz gesagt, die Organisation, die über die Bestimmung des KI-Systems entscheidet, gilt als „neuer“ Anbieter und ist für die Einhaltung der Vorschriften verantwortlich. Der „ursprüngliche“ Anbieter muss dem „neuen“ Anbieter jedoch die technische Dokumentation zur Verfügung stellen, die für die Erfüllung der Anforderungen und Pflichten erforderlich ist. Wir halten diesen Ansatz für sinnvoll und hoffen, dass er in die endgültige Fassung aufgenommen wird.

Anforderungen an KI-Basismodelle und/oder Allgemeinzweck-KI

Die Verhandlungen über das KI-Gesetz spiegeln Markt- und Technologieentwicklungen wider. 2022 stand „KI mit allgemeinem Verwendungszweck“ im Mittelpunkt (siehe neuer Titel IA der allgemeinen Ausrichtung des Rates), während das Jahr 2023 nach der rasanten Akzeptanz von ChatGPT (mit 100 Millionen Nutzern zwei Monate nach der Markteinführung) ganz im Zeichen von generativer KI und KI-Basismodellen steht. Das Europäische Parlament hat vorgeschlagen, Basismodelle unabhängig von deren Risiko zu regulieren und widerspricht damit der ursprünglichen risikobasierten Ausrichtung der Europäischen Kommission. Der Rat muss noch entscheiden, ob der Fokus auf der Einführung von Sicherheitsvorkehrungen für Basismodelle oder Allgemeinzweck-KI (oder auf beidem) liegen soll.

Laut Definition des Parlaments ist ein Basismodell „ein KI-Systemmodell, das auf einer breiten Datenbasis trainiert wurde, auf eine allgemeine Ausgabe ausgelegt ist und an eine breite Palette unterschiedlicher Aufgaben angepasst werden kann“. Das Parlament fordert auch, dass Basismodelle bestimmte Anforderungen erfüllen müssen, bevor sie auf den EU-Markt kommen, und zwar mit Blick auf Risikominderung, Data Governance, „ein angemessenes Niveau an Leistung, Vorhersagbarkeit, Interpretierbarkeit, Korrigierbarkeit, Sicherheit und Cybersicherheit“, Energie- und Ressourceneffizienz, technische Dokumentation, Qualitätsmanagementsystem und Registrierung.

Einige dieser Anforderungen gehen sehr weit, zum Beispiel die Identifizierung, Verringerung und Abschwächung von „vernünftigerweise vorhersehbaren Risiken für Gesundheit, Sicherheit, Grundrechte, Umwelt sowie Demokratie und Rechtsstaatlichkeit“. Es dürfte eine große Herausforderung für Anbieter sein, diese Risiken vorherzusagen und abzuschwächen, da Basismodelle allgemein gehalten sind. Auch die Sicherstellung der Leistungsfähigkeit solcher Modelle über ihren gesamten Lebenszyklus scheint nahezu unmöglich, da der ursprüngliche Anbieter kaum Kontrolle darüber hat, wie das Modell von Dritten eingesetzt wird.

Die Verhandlungsführer von Rat und Parlament müssen sich auf praxistaugliche Anforderungen für (große und kleine) Entwickler und Betreiber von Basismodellen einigen, sonst könnten diese Anforderungen hinderlich für die Entwicklung und den Einsatz von KI in Europa sein. Kai Zenner, Digital Policy Adviser des Abgeordneten Axel Voss, hat vorgeschlagen, diese Anforderungen nur auf systemische Basismodelle anzuwenden, d. h. Basismodelle, die basierend auf Metriken wie der in das Modell investierten Finanzmittel oder der Rechennutzung als „systemrelevant“ erachtet werden.

Generative KI

Das Europäische Parlament hat auch spezifische Regeln für generative KI vorgeschlagen. Generative KI-Systeme, die auf Basismodellen basieren, wie ChatGPT, müssten demnach Transparenzanforderungen erfüllen (d. h. offenlegen, dass der Inhalt durch KI generiert wurde, und bei der Unterscheidung von sogenannten „Deep-Fake“-Bildern von realen helfen) und Sicherheitsvorkehrungen schaffen, die das Generieren illegaler Inhalte verhindern. Auch detaillierte Zusammenstellungen der urheberrechtlich geschützten Daten, die für das Training verwendet wurden, müssten öffentlich verfügbar gemacht werden.

Einige Mitgliedsstaaten wie Frankreich haben Bedenken bezüglich solcher zusätzlichen Verpflichtungen für Basismodelle und generative KI geäußert und sorgen sich um die Auswirkungen einer Überregulierung auf die KI-Innovation in Europa.

KI-Sandbox-Umgebungen

Abschließend wollen wir die Bestimmungen beleuchten, die KI-Innovation fördern sollen. Sie befinden sich am Ende des Gesetzestextes und stellen leider nur einen sehr kleinen Abschnitt der Verordnung dar (nur zwei oder drei Artikel von 85). Das Prinzip von Sandbox-Umgebungen oder Reallaboren ist allgemein bekannt: Innovative KI-Systeme können unter Aufsicht einer zuständigen Behörde entwickelt, trainiert, getestet und validiert werden, bevor sie auf den Markt gebracht werden.

Bezüglich Sandbox-Umgebungen gab es zwei widersprüchliche Ansichten: Mitgliedsstaaten forderten, dass die Schaffung regulatorischer Sandboxes für KI auf nationaler Ebene freiwillig sein sollte, während das Europäische Parlament wollte, dass jeder Mitgliedsstaat bis zum Inkrafttreten der Verordnung mindestens eine nationale KI-Sandbox einrichtet. Einige Mitgliedsstaaten haben hier größere Fortschritte zu verzeichnen als andere. Spanien hat bereits 2022 eine regulatorische KI-Sandbox eingeführt.

Wie man hört, ist über diesen Punkt bereits eine Einigung erzielt worden. Sandboxes sollen verpflichtend sein, aber Mitgliedsstaaten, die sich nicht in der Lage sehen, eine eigene Sandbox zu entwickeln, können sich denen anderer Mitgliedsstaaten anschließen oder eine gemeinsame Sandbox-Umgebung einrichten.

Vorläufige Einschätzung – Scorecard

In dieser Scorecard wollen wir eine erste Einschätzung dazu abgeben, inwieweit die KI-Verordnung voraussichtlich die eingangs in diesem Blog beschriebenen vier „Tests“ besteht.

Wird die KI-Verordnung die vier Tests bestehen?

Ich hoffe, ihr fandet diesen Beitrag zur KI-Problematik nützlich. Wenn ihr einen Blick hinter die Kulissen der Triloge werfen und euch über die Einschätzung eines Insiders zu den Kernfragen informieren möchtet, werft einen Blick auf dieses Interview mit Kai Zenner.

Ich möchte diese Scorecard aktualisieren, wenn der endgültige Wortlaut der KI-Verordnung beschlossen wurde, also vermutlich gegen Ende des Jahres. Bleibt am Ball!

*Dieser Artikel wurde aus dem Englischen übersetzt und editiert. Den Originalblogpost findet ihr hier.

Erfahren Sie mehr

Über Splunk

Die führenden Unternehmen der Welt vertrauen auf Splunk, einem Unternehmen von Cisco, um ihre digitale Resilienz mit der einheitlichen Sicherheits- und Observability-Plattform, unterstützt durch branchenführende KI, kontinuierlich zu stärken.

Unsere Kunden setzen auf die preisgekrönten Sicherheits- und Observability-Lösungen von Splunk, um die Zuverlässigkeit ihrer komplexen digitalen Umgebungen zu sichern und zu optimieren – in jeder Größenordnung.