未経験からLLMの達人へ:Splunkで独自のAIアシスタントを計画、設計、運用化する方法

AIへの熱い期待は、いよいよ最高潮に達しています。ここ数カ月で、その期待は現実のものとなっています。B2Bの世界でも、非常に具体的なユースケースが登場しています。初期テストや「プレビュー」導入によって真のビジネスバリューが実現している様子が観察されました。

このブログ記事では、Zeppelin社の事例を取り上げながら、SplunkのデータをLLMと連携させて活用する方法をご紹介します。同社は建設機械設備、電力システム、レンタル機器、プラントエンジニアリングの販売およびサービスを行う世界的なリーダー企業です。

本題に入る前に:重要なヒント

この記事を読んだ後は、ご自身も実際にプロトタイプを作ってみたくなるでしょう。でも、ちょっと待ってください。

まずは、落ち着いて、以下の内容を盛り込んだプロジェクト範囲を書き出すことが重要です。

- AI導入の目的と目標

- 自社にとってのビジネスバリュー

- 必要なデータ

- データフローの概略

この範囲を決めておくことで、作業内容を検証したり、期待値とのバランスを取ったり、データプライバシーとセキュリティ要件を特定したりするためのガイドラインが確立できます。最後の要素は、どのコンポーネントが使用できるかできないかにも影響します。また、シスコのRobust Intelligenceが提供するAIセキュリティに関するリファレンスアーキテクチャを学ぶこともお勧めです。チャットボット、RAGアプリ、AIエージェントに関する安全なデザインパターンやプラクティスをまとめています。

例えば、クラウドにホストされたLLMに直接接続するか、またはブローカー経由で間接的に接続することで、セキュリティとコンプライアンスの保護を設定できます。こうした保護には、シスコのRobust Intelligenceで得られるキャパシティや監視の機能などが含まれます。ほかのアプローチとして、オンプレミスのアイランドモード(オフライン環境)で事前学習済みモデルを使用したり、データサイエンスと深層学習のためのSplunkアプリケーション(DSDL)に接続されたコンテナに独自のLLMをデプロイしたりできます。

ビジネスケース

実際のプロジェクトに応用できるアーキテクチャの詳細に入る前に、Florian Zug氏が開発してZeppelin社で運用化に成功した例を紹介したいと思います。

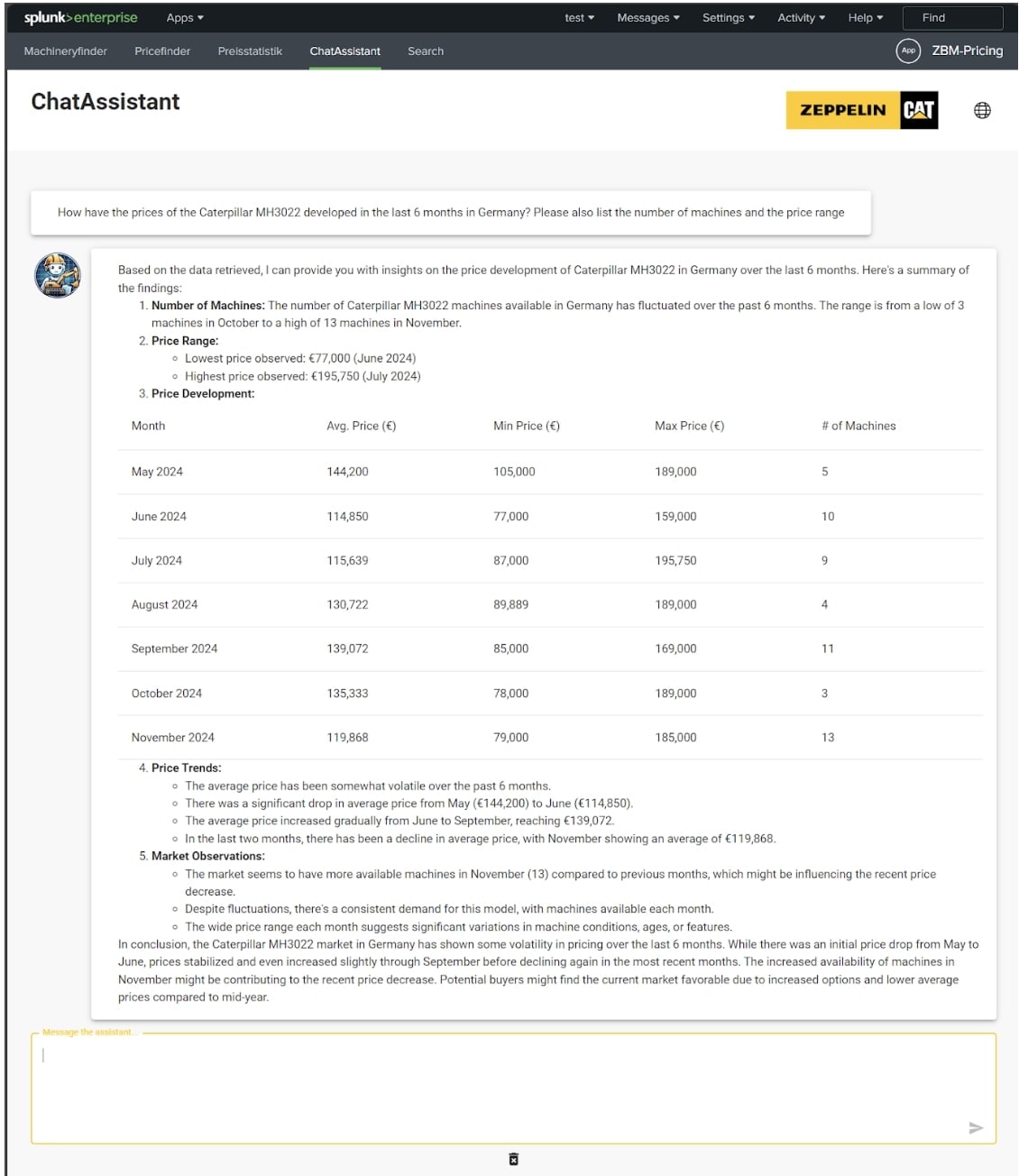

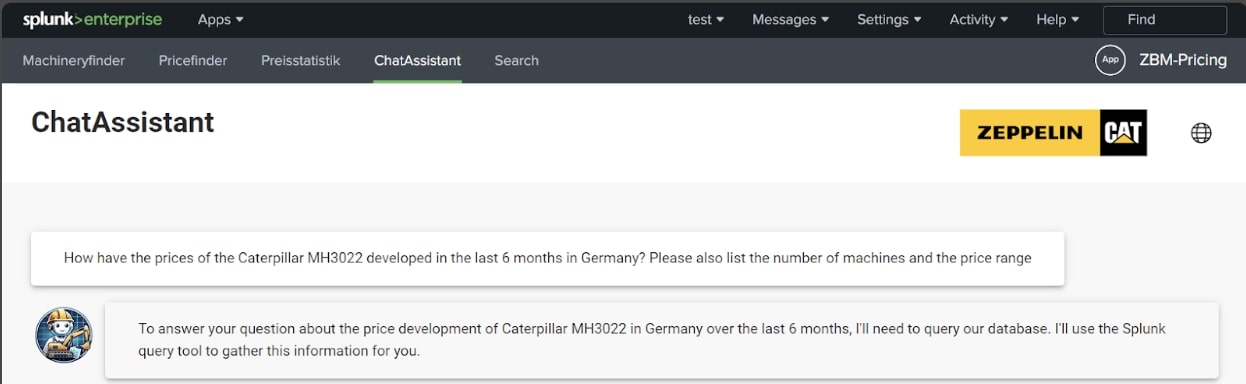

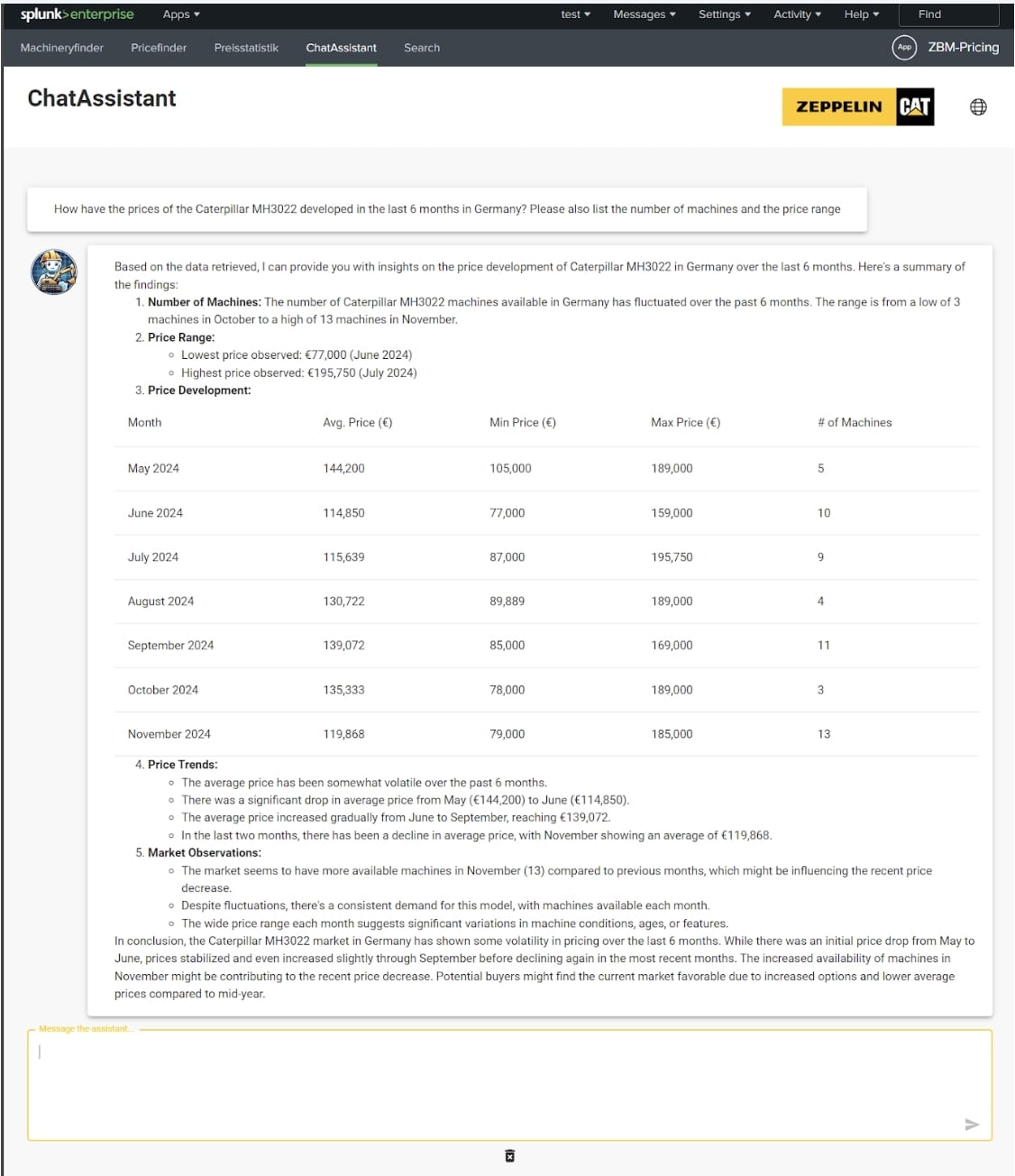

目標は、社員が中古機械設備についてあらゆる価格情報を照会できるAIアシスタントを作ることでした。このデータは、中古機械設備を販売している世界中の多数のウェブサイトから常に価格情報を取得しています。このデータはSplunkに保存されていて、Splunkについての知識がまったくなくても、AI機能によって適切な答えを返せるようになっています。従来型のSplunkダッシュボードまたはSplunk React UIを使用した視覚化で答えることができたのは、ダッシュボードの作成時点で分かっている質問だけでした。AIアシスタントを利用することで、この制限を取り払うことができます。例えば、AIアシスタントに対して、「ドイツ国内におけるキャタピラ社のMH3022の価格は過去6カ月でどう変化していますか?」のようなプロンプトで質問できます。

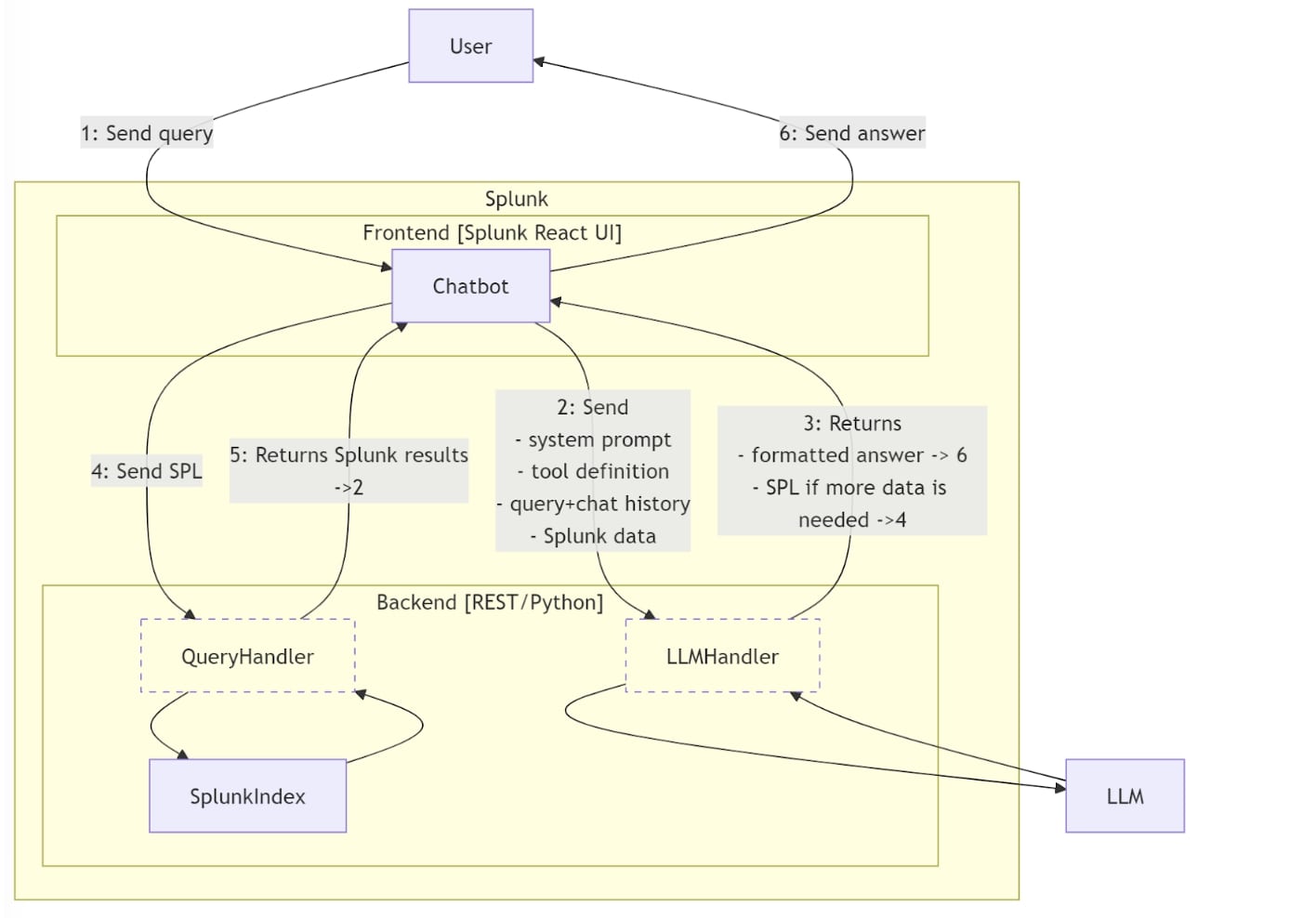

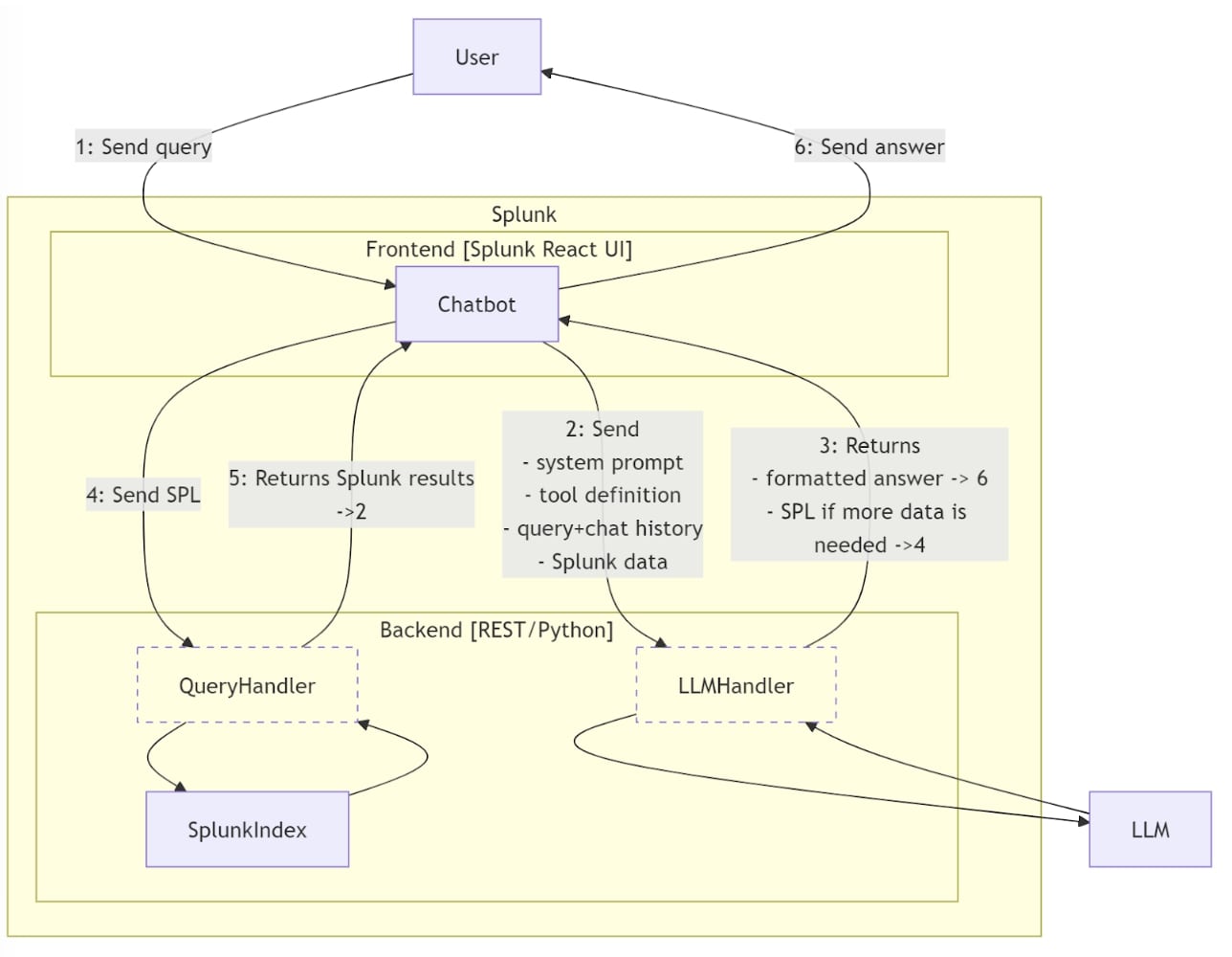

アーキテクチャとデータのフロー

以下のコンポーネントを含め、アーキテクチャの概要を理解することが重要です。

- チャットボット:Splunk内でホストし、Splunk React UIフレームワークを使用して、フロントエンドに応答のロジックを実装します。

- クエリハンドラー:制限付きユーザー(必要なインデックスのみへのアクセス権限)のコンテキスト内でSPLクエリをSplunkに送信し、Splunkデータを返す小さなプロキシ。

- LLMハンドラー:フロントエンドの外部で、LLMの資格情報を管理します。LLMとの間で、リクエストとレスポンスを送受信します。

- Splunkインデックス:中古機械設備の取引のデータを格納しているSplunkのインデックスです。

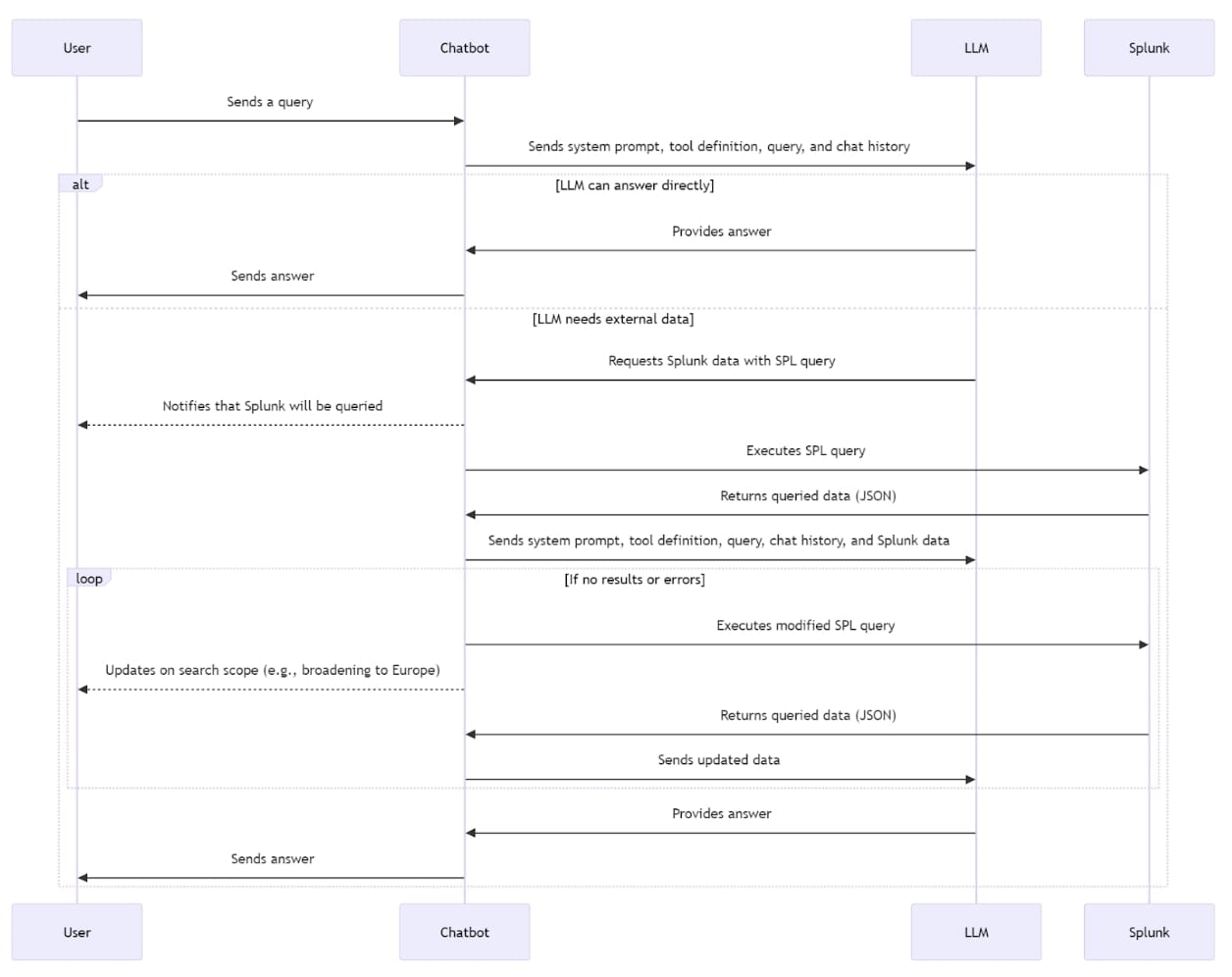

フロー

1. ユーザーが、Splunk内でチャットボットに質問を投げかけます。

2. チャットボットは、LLMハンドラーを通してLLMシステム(Anthropic社のClaudeなど)にリクエストを送信します。リクエストには以下の内容を含めます。

- ユーザーからの質問

- システムプロンプト(チャットボットの挙動、およびSplunk経由で中古機械設備の情報を問い合わせられる能力についての説明)

- ツールの定義(Splunkからのデータが必要な場合には、LLMがSPLを返すよう指定します。また、Splunkインデックスのフィールドや値についての説明も含まれます)

- チャット履歴(完全なチャット履歴が送信されます)

- Splunkデータ(以前に問い合わせがあった場合)

3. LLMは、フォーマットされた回答を返す(ステップ6に進む)か、必要なデータを取得するためのSPLを生成します。

4. SPLが生成された場合は、クエリハンドラーを経由してSplunkに送信されます。

5. 結果が処理されて、チャットボットに返されます。新しいデータとして、ステップ2からフローをやり直します。

6. LLMから完全な回答が返ってきた場合、チャットボットはそれをユーザーに表示します。

SPLクエリに対して何も結果が返ってこなかった場合、LLMは改良したクエリを生成するか、検索範囲を拡大します。例えば、ユーザーがドイツ国内で特定の機械の売買について質問し、Splunkがデータを返せなかった場合、LLMがヨーロッパ全土または全世界での売買についての新しいクエリを生成することが考えられます。

詳細なフロー

ユーザーエクスペリエンス

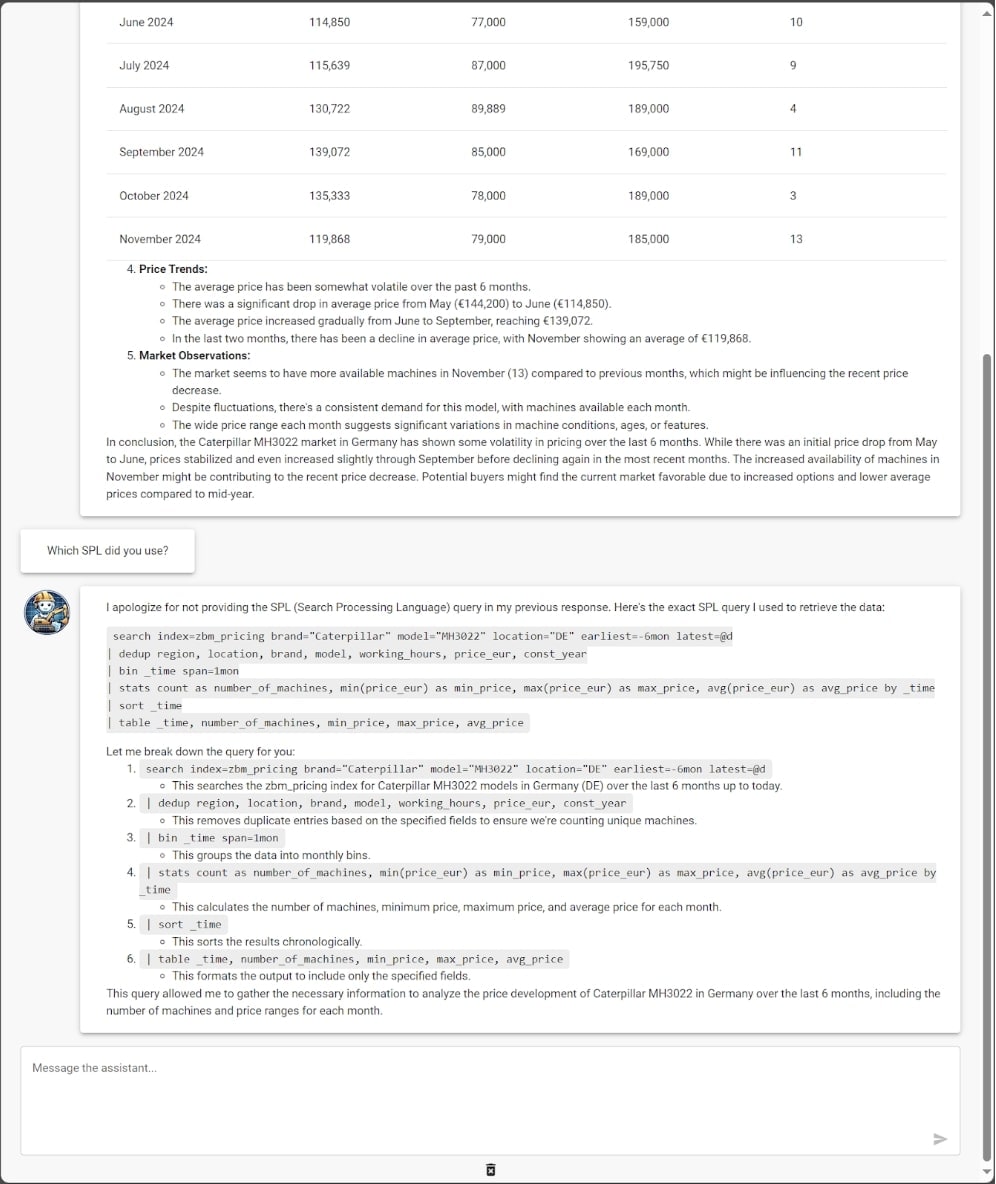

ある質問について生成および使用されたSplunkクエリを詳しく理解するには、同じ会話の中で詳細を問い合わせてみてください。

Florian氏の労力と情熱に感謝します。分かち合うことは思いやりですね。

執筆:Florian Zug氏(Zeppelin社)、Philipp Drieger (Splunk)、Matthias Maier (Splunk)

このブログはこちらの英語ブログの翻訳、内田 大樹によるレビューです。