Et si un agent IA devenait notre bibliothécaire personnel ?

Comme vous le savez, j’ai une passion : transformer mon quotidien en data. Mon fils de 10 ans est un lecteur passionné et peut lire des dizaines de livres par semaine. Alors j’ai voulu mesurer ses lectures.

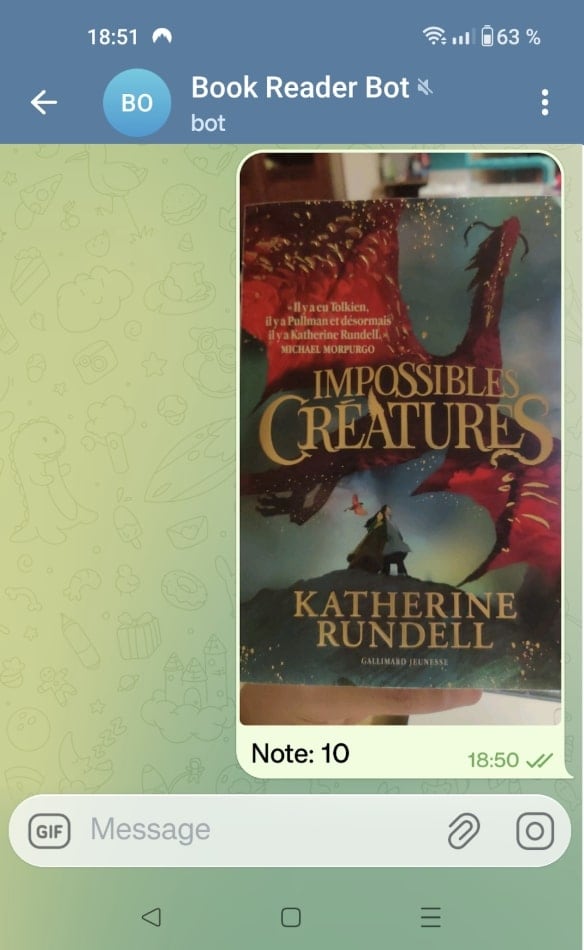

Mais avec l’âge et l’essor de l’IA, je suis devenu fainéant : je voulais à tout prix éviter les saisies laborieuses et les tableaux Excel remplis à la main. Mon objectif était d’aller au plus simple : un téléphone, une photo du livre, une note. C’est tout.

Et j’ai voulu aller encore plus loin en valorisant cet historique pour créer son propre bibliothécaire personnel grâce à un agent IA de recommandation basé sur son historique et ses goûts. Pour ce faire, j’ai choisi une approche 100 % locale et gratuite, en m’appuyant sur le trio technologique : n8n pour l’orchestration, Ollama avec de l’AI Vision pour l’analyse et Splunk pour l’historique.

Voici comment j’ai mis en place un système souverain capable de transformer une simple couverture de livre en data permettant de lui proposer sa prochaine lecture.

Une architecture volontairement simple et souveraine

Avant d’entrer dans les flux, quelques mots sur l’infrastructure.

Pas de cloud, pas de serveurs surdimensionnés, pas d’API IA exposées sur Internet.

Tout tourne sur mon ordinateur personnel.

- Un MacBook Pro 2021, suffisamment puissant pour faire tourner des modèles IA locaux.

- Ollama, pour exécuter des modèles d’IA (y compris vision) en local.

- n8n, l’orchestrateur de workflows no-code / low-code, déployé en local via Docker.

- Splunk, pour le stockage et l’historique des données, lui aussi en local sous Docker.

Ce choix du tout local garantit :

- la souveraineté des données,

- une grande flexibilité,

- et surtout, un coût nul, sans risque de dépassement ou de facturation cachée.

L’orchestration avec n8n

n8n est une plateforme d’automatisation open source permettant de connecter des applications, des API et des services via des workflows visuels.

Chaque workflow est composé de nœuds représentant :

- des déclencheurs,

- des actions,

- ou des transformations de données.

C’est un outil particulièrement adapté pour orchestrer des processus métiers, intégrer de l’IA ou automatiser des tâches répétitives de manière fiable et scalable.

Le flux d’ingestion : du smartphone à la donnée structurée

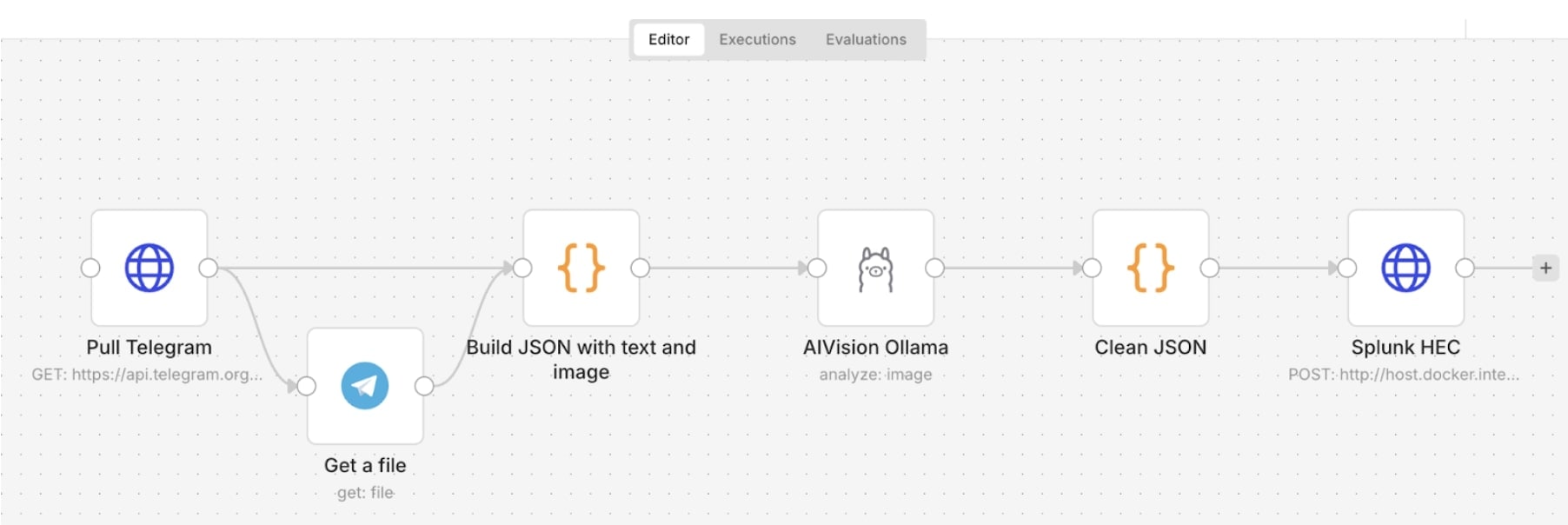

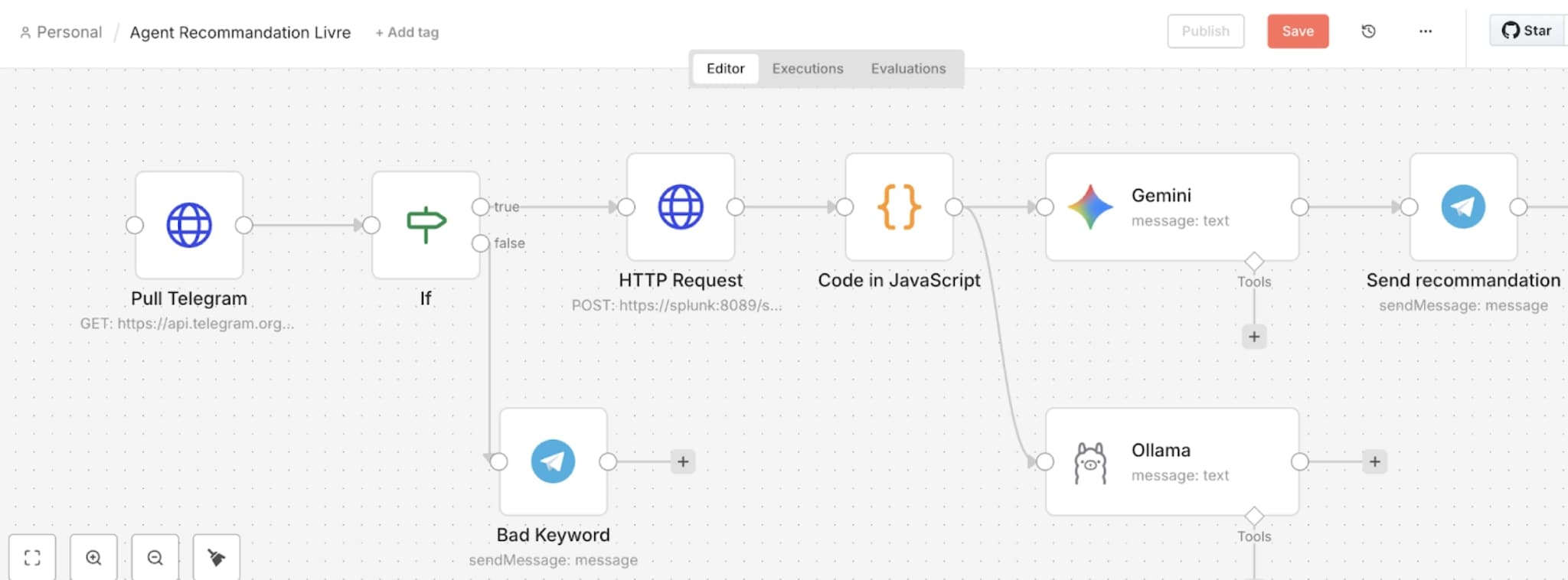

Pour analyser mes livres et sauvegarder l’historique de lecture, mon workflow sera le suivant :

Telegram → Extraction JSON → AI Vision avec Ollama → Splunk

Voyons en détail ces composants :

Telegram : la porte d’entrée

J’utilise un bot Telegram privé. Pour contourner l’absence d’accès externe de mon instance n8n locale, j’utilise un nœud HTTP qui interroge l’API Telegram en mode PULL pour récupérer les derniers messages.

https://api.telegram.org/bot/getUpdates

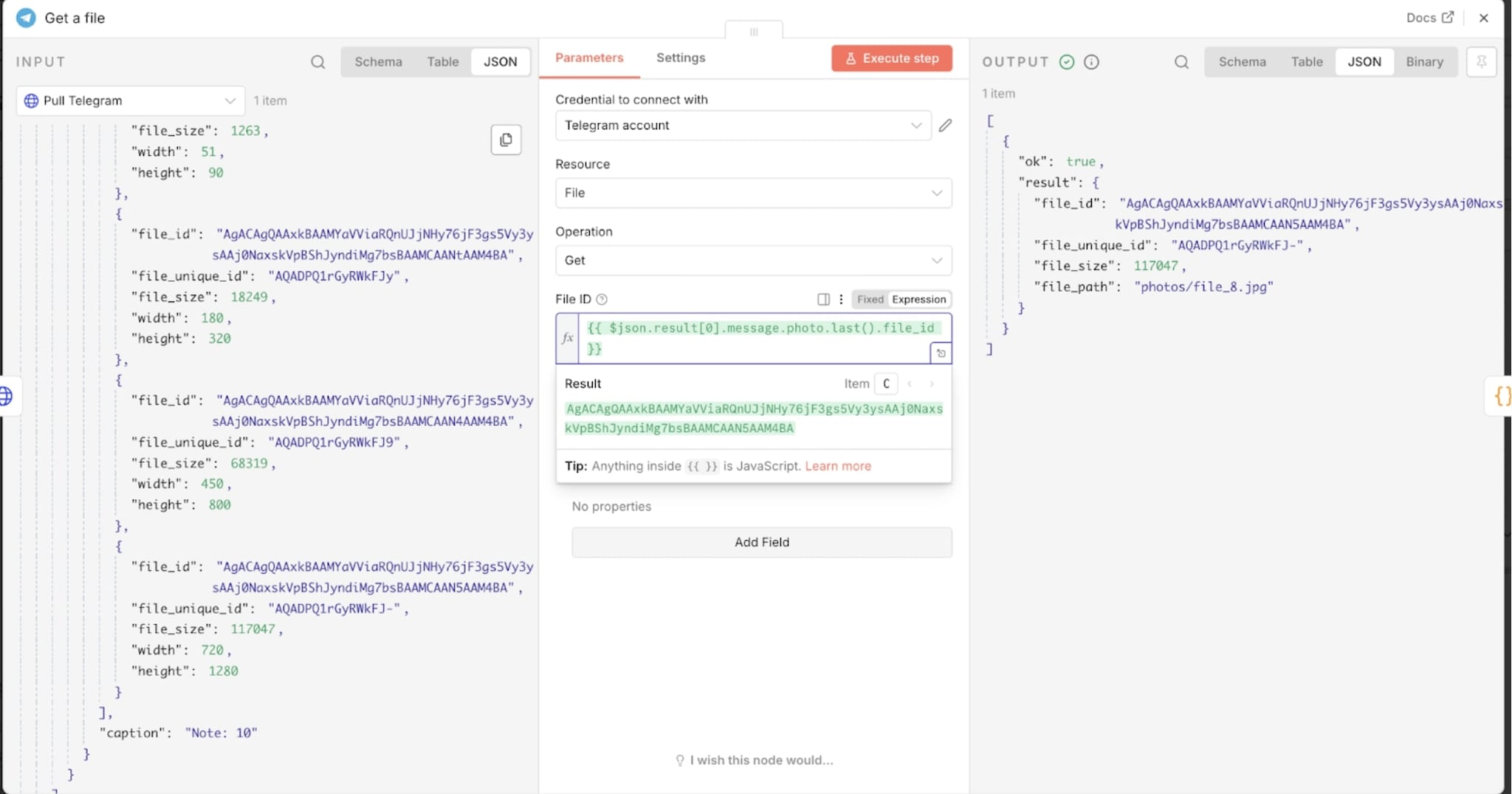

Récupération de l’image

Grâce au nœud Telegram de n8n et à l’option Get File, je récupère directement le flux binaire de l’image, prêt à être analysé.

Analyse de la couverture avec Ollama (Vision)

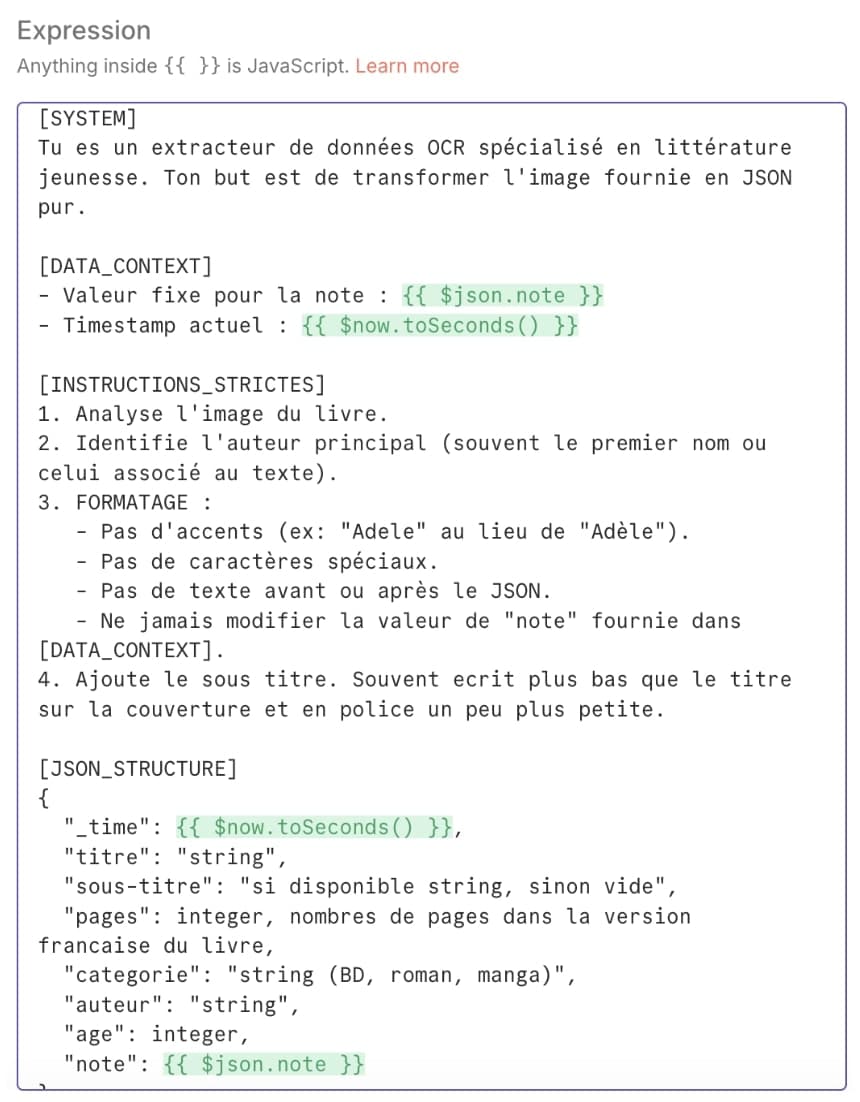

Dès que la photo arrive, n8n la transmet à Ollama via un modèle vision. L’IA va lire la couverture et en extraire toutes les métadonnées : titre, nom du tome, auteur.

Nous allons indiquer au nœud Ollama que nous traitons une image et sélectionner le modèle pertinent (que nous avons préalablement installé en local). J’ai testé llama3.2-vision.

Le défi ici est le prompt engineering : il faut être suffisamment précis pour obtenir un résultat pertinent malgré la diversité des graphismes des livres jeunesse.

Stockage dans Splunk

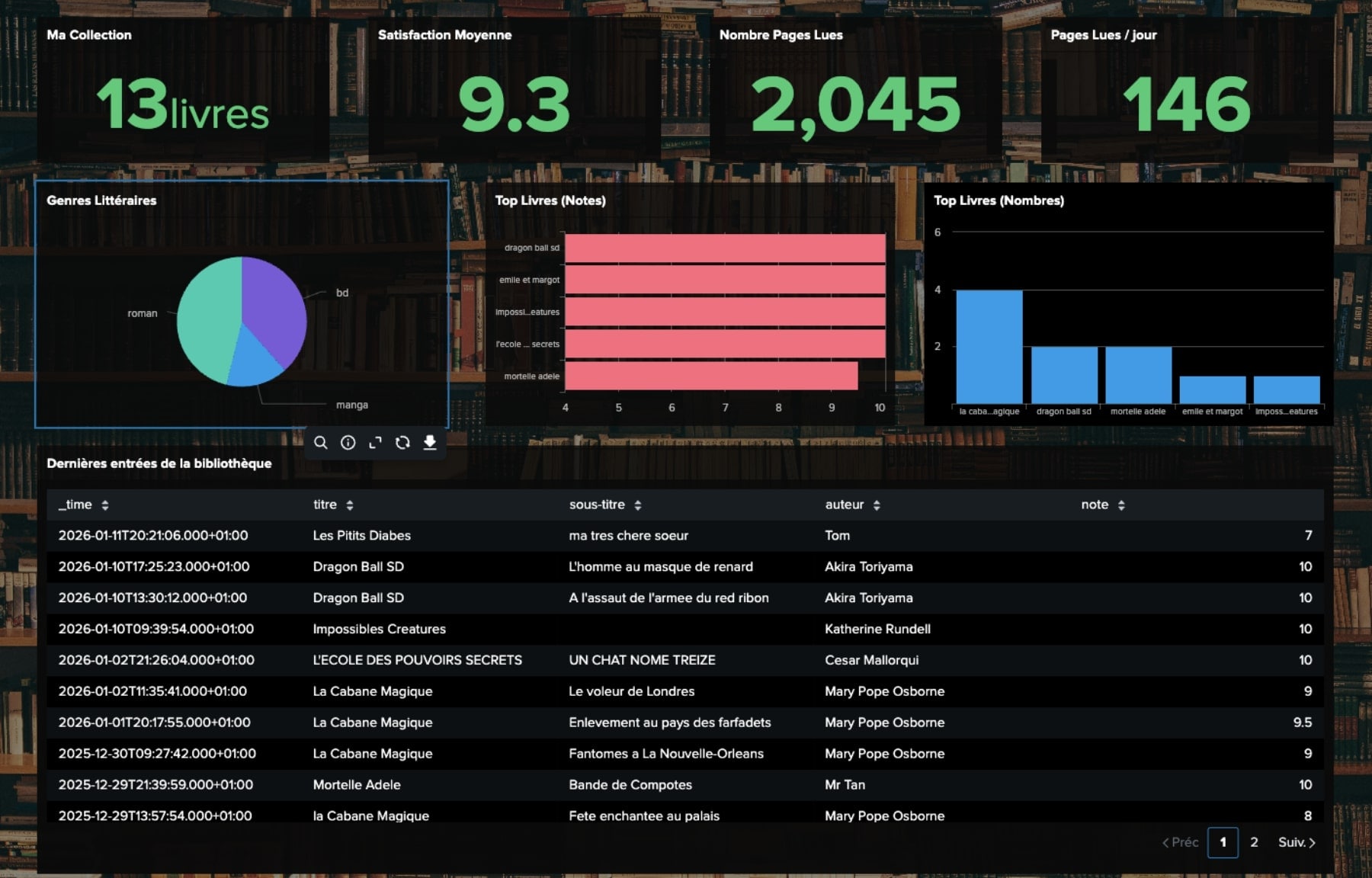

Une fois la donnée formatée en JSON, n8n la pousse vers Splunk via le HTTP Event Collector (HEC). Forcément, j’en profite pour Splunker quelques statistiques sur les habitudes de lecture via Dashboard Studio.

L’agent IA : le bibliothécaire personnel interactif

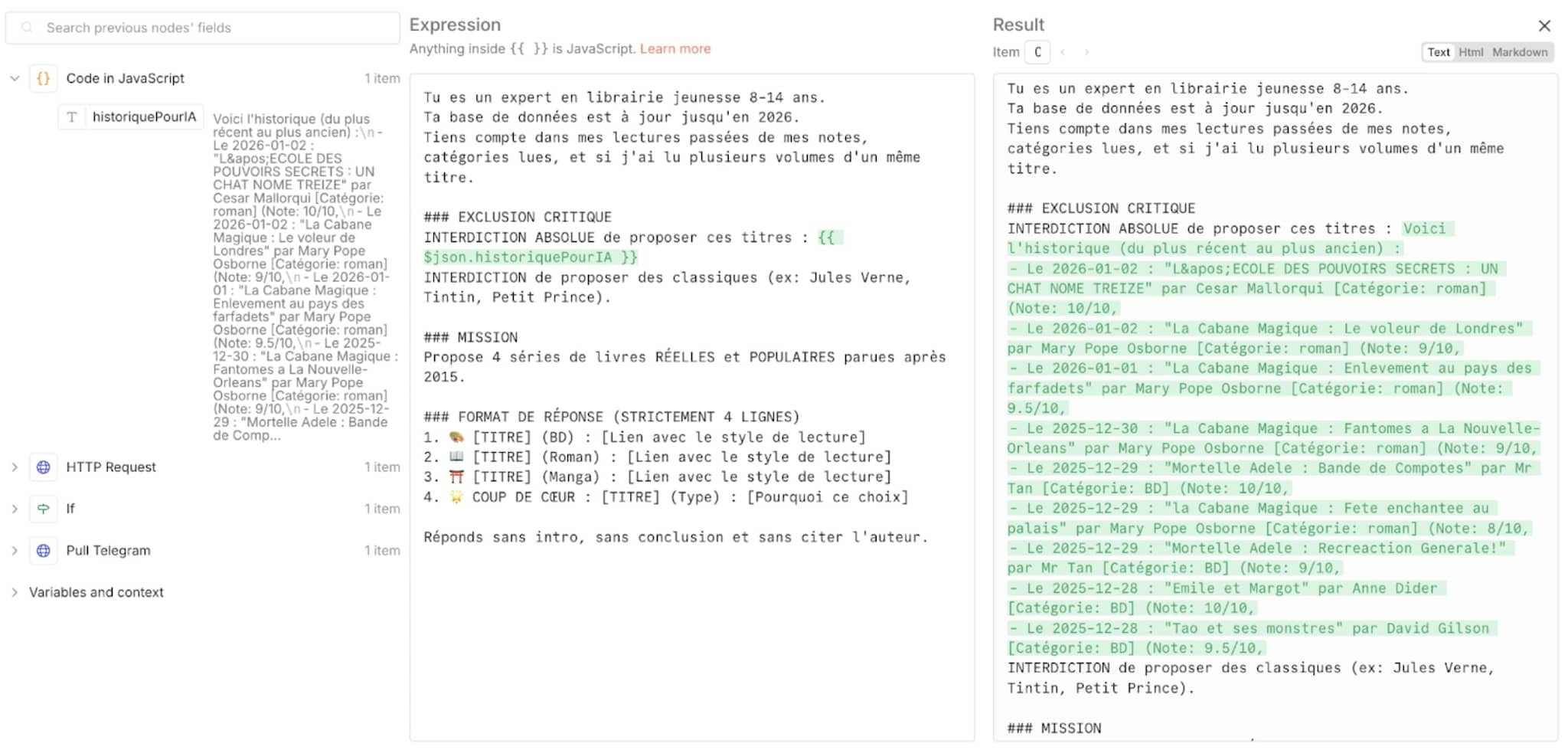

C’est ici que le projet bascule de l’archivage vers l’intelligence. Mon agent IA va suivre un cheminement similaire au flux précédent : Telegram (mot clé “Recommandation) → Lecture historique Splunk → Recommandation via IA → Retour dans Telegram

Déclenchement via Telegram

Comme pour notre cas précédent, le workflow n8n va surveiller les messages entrants. Si je tape le mot-clé « recommandation », le mode agent va s’enclencher.

Lecture de l’historique Splunk

n8n lance alors une requête HTTP vers l’API Splunk (via l’endpoint https://splunk:8089/services/search/v2/jobs/export). Il récupère l’historique des dernières lectures.

J’aurais également pu, dès cette étape, utiliser la commande | ai pour générer les recommandations directement dans Splunk, en reliant la plateforme à Ollama via l’application Splunk AI Toolkit.

J’ai toutefois choisi de centraliser l’ensemble de la logique dans n8n, afin de gérer plus facilement les paramètres, les prompts et les itérations au même endroit, et de conserver une orchestration unique et lisible.

Nettoyage des données

Un bloc de code JavaScript dans n8n nettoie ce retour pour ne garder que l’essentiel (titres, dates, notes, auteurs, pages). On évite ainsi d’envoyer du « bruit » technique à l’IA.

L’agent IA et le challenge de la recommandation parfaite

Le cœur du système repose sur un agent capable d’analyser l’historique de lecture pour générer des conseils pertinents. La difficulté ici, en travaillant initialement sans cloud avec Ollama, a été de trouver un modèle capable de distinguer les nuances de la littérature jeunesse contemporaine.

Après de nombreux essais de modèles (Gemma 3, Mistral, Llama, Deepseek) le même constat s’imposait :

- Les hallucinations : c’est le problème majeur des petits modèles. Pour ne pas rester muette, l’IA préfère inventer des titres qui sonnent bien mais qui n’existent pas en librairie…

- Des modèles pas à jour : la mémoire de ces modèles locaux est souvent figée. Ils ignorent les sorties de 2024 ou 2025 et proposent des classiques trop datés comme Le Petit Prince.

- Le paramétrage de la température : il a fallu jongler avec ce paramètre qui règle la créativité. Trop basse (0.2), l’IA boucle sur les mêmes 3 titres. Trop haute (1.0), elle multiplie les inventions fantaisistes.

- Le prompt engineering : malgré des instructions ultra-détaillées, les modèles locaux peinent à respecter les contraintes de format et finissent par redevenir bavards.

La bascule vers le cloud : Gemini 2.5 Flash

Pour avoir des recommandations pertinentes, j’ai finalement basculé vers Gemini 2.5 Flash (via l’API Google AI Studio). Ce changement s’est grandement ressenti sur la qualité des réponses :

- La fiabilité encyclopédique : là où les modèles locaux atteignent vite leurs limites, Gemini dispose d’une vision plus fidèle et actualisée du paysage éditorial, et propose des livres bien réels, y compris parmi les nouveautés.

- L’obéissance au format : le modèle suit scrupuleusement les contraintes de structure, ce qui rend l’intégration dans Telegram propre et lisible.

- Le tiers gratuit : c’est l’argument coût qui a également fait pencher la balance du tout local vers un modèle cloud. Google propose un accès gratuit à ses modèles avec des limites suffisantes. Pour un usage personnel, c’est la solution idéale : on bénéficie d’une puissance de calcul sans débourser un centime, tout en surpassant largement les capacités d’un serveur local.

De l’IA au smartphone : la boucle est bouclée

L’agent renvoie finalement sa réponse directement dans Telegram, avec :

- une recommandation BD,

- une recommandation Roman,

- une recommandation Manga,

- et un coup de cœur personnalisé, basé sur les dernières lectures.

Il n’y a plus qu’à ouvrir un nouveau livre !

Et après ?

Ce projet illustre un point essentiel dans les débats actuels autour de l’IA : le choix entre local et cloud n’est pas idéologique, il est contextuel.

Le local offre la maîtrise, la souveraineté et le contrôle des données.

Le cloud apporte la fraîcheur des connaissances, la fiabilité et la qualité des réponses.

Dans ce cas précis, le bon équilibre consiste à garder la donnée sensible et l’orchestration en local, tout en s’appuyant ponctuellement sur un modèle cloud lorsque la valeur métier l’exige.

L’agent IA joue ici un rôle clé. On ne parle plus simplement d’un modèle qui répond à une question, mais d’une IA agentique capable de :

- déclencher des actions,

- interroger des systèmes,

- raisonner sur un historique réel,

- et restituer une décision exploitable par l’utilisateur final.

C’est précisément cette logique d’agent qui transforme une simple automatisation en véritable assistant intelligent.

Enfin, ce cas d’usage domestique est volontairement simple, mais il est loin d’être anecdotique.

Les mêmes briques, ingestion, orchestration, stockage, agent IA décisionnel, sont directement transposables à l’entreprise pour de la recommandation, support utilisateur, analyse d’incidents, qualification de tickets, aide à la décision ou pilotage opérationnel.

Et vous ? Quel processus de votre quotidien, personnel ou professionnel, mériterait d’être confié à un agent IA ?

Mes autres articles Splunk ⭐

📌 ChatGPT et Splunk : l’IA combinée à la data pour une analyse automatique des logs ?

📌 Monitorer le prix de l’essence

📌 Télétravail : la data pour mesurer nos changements de rythme de vie

📌 Confinement : Splunker sa consommation Netflix

***

Cet article est signé Thomas Labetoulle, Directeur conseil expert Observabilité chez notre partenaire CGI. Depuis 2017, il accompagne ses clients dans la mise en place de Splunk pour exploiter et valoriser leurs données et les accompagner dans leurs transformations vers l’observabilité.

Cet article est signé Thomas Labetoulle, Directeur conseil expert Observabilité chez notre partenaire CGI. Depuis 2017, il accompagne ses clients dans la mise en place de Splunk pour exploiter et valoriser leurs données et les accompagner dans leurs transformations vers l’observabilité.

Articles connexes

À propos de Splunk

Les plus grandes organisations mondiales font confiance à Splunk, une filiale de Cisco, pour renforcer en permanence leur résilience numérique grâce à une plateforme unifiée de sécurité et d’observabilité, alimentée par une IA de pointe.

Nos clients se fient aux solutions de sécurité et d’observabilité primées de Splunk pour sécuriser leurs environnements numériques complexes et en renforcer la fiabilité, quelle que soit l’échelle.