Vague de chaleur sur les données : comment éviter la surchauffe ?

Il suffit d’avoir vécu les récentes vagues de chaleur pour saisir pleinement le sens du mot « résilience ». Face à ces températures extrêmes, notre corps réagit : il ralentit, s’ajuste, s’adapte. Instinctivement, nous cherchons la fraîcheur, limitons nos efforts et nous nous hydratons régulièrement. Plus nous sommes préparés à ces conditions exceptionnelles, mieux nous pouvons les traverser et affronter celles qui pourraient encore survenir. Et c’est pareil dans le monde numérique.

Les raisons de la surchauffe de données

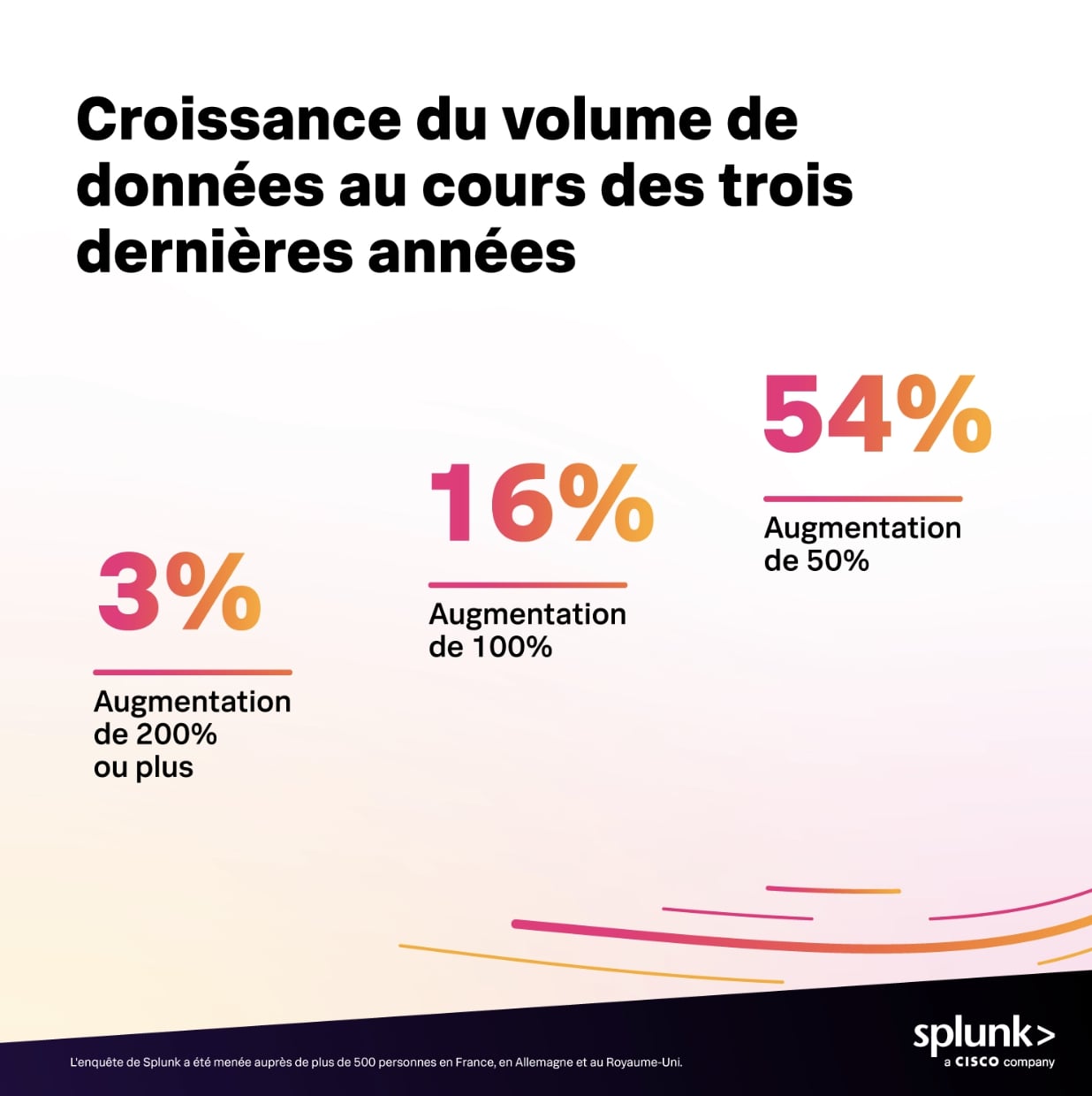

Les derniers rapports de Splunk révèlent que les entreprises font face à une véritable « vague de chaleur numérique » :

- Les volumes de données connaissent une croissance exponentielle, alimentée par une diversité de sources telles que le cloud, les objets connectés, les applications SaaS ou encore les environnements industriels. Cette explosion de données s’accompagne de nouvelles réglementations, qui exigent une visibilité accrue sur des périmètres toujours plus étendus.

- La variété et la dispersion des sources de données complexifient leur collecte, leur structuration et leur stockage, tant pour satisfaire les exigences réglementaires que pour répondre aux besoins des métiers.

- Dans ce contexte, les équipes IT et sécurité doivent composer avec une multitude d’outils cloisonnés, freinant l’interopérabilité et la collaboration. Cette fragmentation nuit à l'efficacité des processus de détection, d’investigation et de résolution des incidents.

Ce ne sont là que quelques exemples qui illustrent l’importance d’une bonne préparation pour éviter une véritable « insolation numérique », d’autant plus que ces enjeux deviendront encore plus cruciaux avec la montée en puissance de l’intelligence artificielle.

Les nouvelles règles de la gestion des données

À l’ère de l’intelligence artificielle, des environnements hybrides et de l’évolution rapide des réglementations, les entreprises doivent repenser radicalement la façon dont elles gèrent leurs données.

Loin des approches centralisées rigides du passé, les leaders de demain placent la donnée au cœur de leur stratégie numérique à travers trois leviers essentiels :

- une collecte ciblée, qualitative et sécurisée pour répondre aux exigence des métiers et des réglementations,

- une interopérabilité des outils pour améliorer la visibilité et optimiser les processus,

- une réutilisation des données pour tirer un maximum de valeur des données.

Face aux volumes qui explosent, la collecte des données est devenue un enjeu stratégique. 67 % des entreprises déclarent que le volume et la croissance des données constituent un défi à la mise en œuvre de leur stratégie de données et donc à la prise de décision. 53 % des entreprises françaises ont peiné à se conformer aux réglementations au cours des trois dernières années en raison du volume de données à traiter*.

Les leaders repensent la collecte par une approche sélective et intelligente. Ils adoptent des pratiques comme le tiering pour stocker les données en fonction de leur valeur, leur fréquence d’accès ou leur criticité afin de réduire les coûts de stockage, limiter la redondance et permettre un accès rapide aux données critiques.

La standardisation des méthodes de collecte constitue également un enjeu majeur. Le déploiement à grande échelle et de manière transverse d’OpenTelemetry, par exemple, permet aux différentes équipes de s’aligner autour d’un langage commun pour l’implémentation des collectes de données. Cela favorise l’unification des couches de collecte, tout en restant indépendant des outils ou plateformes utilisés pour exploiter ces données, qu’ils soient dédiés à la sécurité, à l’observabilité ou à d’autres besoins.

La qualité des données constitue un aspect essentiel de la stratégie de gestion des données, offrant aux organisations de multiples axes d'optimisation financière et d’amélioration des processus d’entreprise. Le filtrage, l’enrichissement, la normalisation des données au plus tôt dans le processus de collecte permet d'optimiser les coûts et de se concentrer sur des données qualitatives (Edge Processor) pouvant être interrogées efficacement.

Si la collecte permet de structurer, la fédération permet d’unifier. Le concept de fédération est un élément central de la plateforme de données Splunk. Il permet d’interroger des sources multiples, depuis le même endroit, sans devoir physiquement les centraliser. Cela évite les coûts de migration, limite les duplications et accélère l’accès aux informations pertinentes.

En effet, trop souvent, les entreprises dupliquent leurs données pour des usages cloisonnés : sécurité, analyse métier, observabilité. Cette pratique, en plus d’être coûteuse, engendre des angles morts et nuit à la cohérence stratégique globale de besoin de visibilité cross-plateforme pour l’ensemble des métiers de l’entreprise.

Collecter mieux, interroger sans déplacer, exploiter sans dupliquer : voilà les nouveaux piliers d’une gestion des données efficace et résiliente. Les entreprises qui adoptent ces pratiques réduisent non seulement leurs coûts, mais renforcent aussi leur sécurité, leur conformité et leur réactivité.

La sécurité des systèmes passe désormais par une gestion intelligente des données et une refonte des approches de détection et de réponse

En matière de cybersécurité, les équipes de sécurité (SecOps) sont confrontées aux mêmes défis avec un challenge supplémentaire lié à l’intensification des menaces cyber portée notamment par l’usage des IA.

Le SOC doit devenir un centre nerveux unifié, capable d’agir vite, de voir clair et de se réinventer en continu. Deux stratégies s’imposent : maîtriser les données, puis réinventer la chaîne de détection et de réponse aux incidents de sécurité.

Le dernier rapport de Splunk sur la gestion des données pour les équipes sécurité est édifiant sur ce point.

La génération de données doit dépasser les 394 zettaoctets d’ici 2028, avec une pression réglementaire (NIS2, CRA, DORA…) exponentielle imposant une sécurisation croissante des données, qui est d’autant plus importante et nécessaire que le coût moyen d’une faille de données est estimé à environ 4 350 000 dollars !

L’approche unifiée de gestion des opérations de sécurité proposée par Splunk s’appuie sur plusieurs piliers :

L’approche unifiée de gestion des opérations de sécurité proposée par Splunk s’appuie sur plusieurs piliers :

- la détection basée sur de l’analyse comportementale, de la contextualisation dynamique et l'intégration de frameworks comme MITRE ATTACK ou ICS,

- l’investigation depuis une console unifiée connectée aux sources de données,

- la réponse automatisée via des playbooks SOAR.

Combinée à une approche « plateforme » unifiée, la gestion intelligente des données permettra de briser les silos, de fluidifier la collaboration entre équipes, et d’apporter une vision commune et contextualisée des risques, des incidents et des performances.

Si vous souhaitez en savoir plus, voici quelques ressources utiles :

- La gestion des données pour les équipes de sécurité

- Les nouvelles règles de la gestion des données

- Le guide du TDIR pour le SecOps

- L’article de Petra Jenner sur le sujet de la gestion des données

*Méthodologie

Cette étude a été menée par le cabinet OnePoll pour le compte de Splunk entre le 17 et le28 avril 2025 auprès de 500 décisionnaires IT français issus d’entreprises de plus de 250 employés.

Elle a également été réalisée auprès d’un échantillonnage similaire au Royaume-Uni et en Allemagne.

Articles similaires

À propos de Splunk

Les plus grandes organisations mondiales font confiance à Splunk, une filiale de Cisco, pour renforcer en permanence leur résilience numérique grâce à une plateforme unifiée de sécurité et d’observabilité, alimentée par une IA de pointe.

Nos clients se fient aux solutions de sécurité et d’observabilité primées de Splunk pour sécuriser leurs environnements numériques complexes et en renforcer la fiabilité, quelle que soit l’échelle.